« Si je demande à Google Traduction de traduire « Je suis professeur » en italien, il utilisera le mot masculin pour professeur, à moins que je n’indique spécifiquement que je suis une femme professeur. »

(COMMUNIQUÉ DE PRESSE) GRONINGEN, 21-Nov-2022 — /EuropaWire/ — L’Université de Groningue, l’une des universités les plus traditionnelles et les plus prestigieuses des Pays-Bas, a annoncé que sa professeure de linguistique computationnelle et société, Malvina Nissim , tiendra sa conférence inaugurale sur la réduction des préjugés dans les programmes informatiques le 2 décembre 2022 à l’Aula Academy Building, Broerstraat 5, Groningen. Elle discutera du potentiel et des risques de la technologie du langage, qui s’est développée si incroyablement rapidement ces dernières années que nous ne pouvons plus imaginer la vie sans elle. Par exemple, des applications telles que la correction automatique, Google Translate et Siri sont intégrées dans notre vie quotidienne. Selon le professeur, de tels développements ne sont pas sans risques et ce qui l’inquiète est le fait que les utilisateurs s’arrêtent rarement pour considérer le rôle actif qu’ils jouent eux-mêmes dans le développement de la technologie du langage.

Nous disons à Siri d’appeler “maison” pour nous éviter d’avoir à entrer un numéro. Nous utilisons Google Traduction pour traduire des textes et nous obtenons Word pour vérifier notre orthographe. Et dans WhatsApp, nous n’avons qu’à taper quelques lettres et nous avons le choix entre un certain nombre de mots possibles. Ces applications et les nombreux autres services et applications que tant d’entre nous ont adoptés sont basés sur la linguistique computationnelle : le domaine où la linguistique et l’intelligence artificielle se rencontrent.

Traductions étranges

Ce n’est pas une surprise pour Malvina Nissim que nous aimions tous tant la technologie. ‘Je suis trop. En tant qu’Italien travaillant dans une université néerlandaise, je reçois toujours des documents rédigés en néerlandais. Il me faut des années pour les parcourir tous, alors parfois je demande à Google Translate de m’aider. Il y a quelques années, les traductions qu’il générait étaient souvent assez bizarres, mais aujourd’hui, elles sont vraiment bonnes. Bon, mais pas parfait. Les ordinateurs font des erreurs.

Par exemple, les choses peuvent mal tourner si une expression familière est traduite littéralement. Chaque mot peut avoir été traduit correctement, mais le sens est perdu. Des erreurs peuvent également surgir, explique Nissim, de préjugés qu’une machine de traduction a été enseignée, même à contrecœur. `Prenez ma langue maternelle, l’italien. L’italien marque le genre, ce qui signifie que ses mots peuvent avoir une version masculine et une version féminine. Il faut toujours faire un choix. Je suis une professeure : una professoressa. Un professeur de sexe masculin est un professore. Mais si je demande à Google Translate de traduire “Je suis professeur”, cela ira pour le mot masculin pour professeur, à moins que je n’indique spécifiquement que je suis une femme professeur.

Prejudices and stereotypes

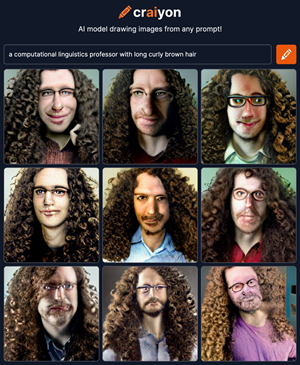

De tels préjugés ne sont pas propres aux machines de traduction. Si vous recherchez des images de professeurs sur Google, la plupart des images que vous obtiendrez seront des hommes blancs avec des lunettes, debout devant des tableaux noirs à l’ancienne. “Ou il existe un système récent, Crayon AI”, dit Nissim, “qui dessine des images en fonction d’invites de texte. Si je veux qu’il me dessine et que je tape : “un professeur de linguistique informatique aux cheveux longs, bruns et bouclés”, cela me donne neuf options. Et tous les neuf sont des hommes blancs avec de longs cheveux bruns et bouclés et des lunettes.

Nissim s’empresse de souligner que simplement blâmer la technologie pour ces préjugés serait myope. « Nous développons ces programmes en montrant à l’ordinateur de nombreux exemples. Et ces exemples sont tirés de textes, d’images, etc., que vous et moi laissons sur des sites Web et dans des documents. Les programmes apprennent du langage que nous utilisons. Ils ne font qu’adopter les préjugés et les stéréotypes que nous avons exprimés, le plus souvent sans pouvoir les nuancer.» C’est un fait qu’il y a plus d’hommes que de femmes dans les postes à responsabilité, comme celui de professeur, et nous terminons parler et écrire plus sur les professeurs masculins que féminins. “Mais les femmes professeurs existent bien sûr, et c’est une connaissance que l’ordinateur doit acquérir”, dit Nissim.

Réduire les préjugés dans les programmes informatiques est certainement possible, mais ce n’est pas facile. “Cela implique d’intervenir au stade du développement et de décider également ce qui est un préjugé et ce qui ne l’est pas”, explique Nissim. “Le genre est un exemple assez clair, même lorsqu’il est simplement considéré sous une forme binaire simplifiée, mais il existe d’autres préjugés qui sont beaucoup plus subtils et donc beaucoup plus difficiles à combattre.” Un autre problème est que les données ne sont pas représentatives de la société en tant que telle. ensemble. «Tout le monde n’est pas actif en ligne et tout le monde n’est pas représenté dans les données utilisées pour former des modèles informatiques. Par exemple, certaines langues sont beaucoup moins utilisées que d’autres et certains groupes ethniques sont sous-représentés. Nous devons également en être conscients lorsque nous utilisons des données pour créer de nouvelles applications. »

“Il est important pour nous tous de réaliser que ces programmes informatiques ne sont pas objectifs et que tout ce que nous trouvons en ligne n’est pas vrai.”

Sensibilisation

Afin de transmettre cette prise de conscience aux générations futures, Nissim et ses collègues ont développé une série de conférences pour les étudiants de troisième année en sciences de l’information à la Faculté des arts sur les aspects éthiques de la linguistique informatique. `C’est la nouvelle génération qui fera des applications à l’avenir. En plus d’acquérir des connaissances techniques, il est important pour eux de réfléchir à l’impact potentiel de la technologie qu’ils développent.

Nissim veut faire passer ce message non seulement aux programmeurs mais aussi aux utilisateurs. “Il est important pour nous tous de réaliser que ces programmes informatiques ne sont pas objectifs et que tout ce que nous trouvons en ligne n’est pas vrai”, dit-elle. `Il existe maintenant des programmes capables de créer des vidéos extrêmement réalistes basées sur du texte. Ils ont l’air incroyablement réels, mais rien de ce que vous voyez dans la vidéo ne s’est réellement produit. Les outils qui sont développés pour détecter les fausses informations s’améliorent de mieux en mieux, c’est vrai, mais la technologie utilisée pour concocter ces informations progresse tout aussi rapidement.

Cela dit, la dernière chose que veut Nissim, c’est que les gens aient peur de la technologie. `C’est fantastique de voir tout ce qui peut être fait, et bien sûr nous voulons exploiter pleinement tout ce potentiel. C’est juste que nous devons être conscients que les programmes informatiques ne sont pas parfaits. Nous devons rester critiques lorsque nous décidons de la manière d’appliquer ce qui est technologiquement possible, et cela nécessite que les personnes et les machines travaillent ensemble. Tant que nous faisons cela, nous pouvons continuer à accueillir de nouveaux développements.

À propos de Malvina Nissim

La professeure Malvina Nissim (1975) a étudié la linguistique à l’Université de Pise et a obtenu son doctorat en 2002 pour une thèse intitulée “Bridging Definites and Possessives: Distribution of Determiners in Anaphoric Noun Phrases”. Elle a travaillé dans des instituts de recherche à Édimbourg, Rome et Bologne avant de rejoindre la Faculté des arts de l’Université de Groningue en 2014, où elle a été nommée professeur de linguistique computationnelle et société en 2020. Elle a été élue UG Lecturer of the Year en 2017.

Nissim dirige une équipe de recherche qui travaille actuellement au développement d’applications prenant en charge l’interaction basée sur le langage. L’équipe utilise des modèles informatiques pour étudier le fonctionnement du langage et de la communication basée sur le langage. Une publication récente écrite par Nissim avec le doctorant UG Gosse Minnema, chercheur UG Dr. Tommaso Caselli, et deux collègues de l’Université de Pavie (Chiara Zanchi et Sara Gemelli) sur la recherche en linguistique computationnelle à fort impact social viennent d’être sélectionnés comme meilleur article lors d’une conférence internationale sur les technologies du langage.

Plus d’informations

- Malvina Nissim

- Nissim tiendra sa conférence inaugurale le vendredi 2 décembre.

By Marjolein te Winkel / Photos Henk Veenstra

AVIS DE NON-RESPONSABILITÉ: La version française de ce communiqué de presse est une traduction du communiqué de presse original, qui est rédigé en anglais, et est uniquement à des fins d’information. En cas de divergence, la version anglaise de ce communiqué de presse prévaudra.

SOURCE: University of Groningen

- Aortic Aneurysms: EU-funded Pandora Project Brings In-Silico Modelling to Aid Surgeons

- BREAKING NEWS: New Podcast “Spreading the Good BUZZ” Hosted by Josh and Heidi Case Launches July 7th with Explosive Global Reach and a Mission to Transform Lives Through Hope and Community in Recovery

- Cha Cha Cha kohtub krüptomaailmaga: Winz.io teeb koostööd Euroopa visionääri ja staari Käärijäga

- Digi Communications N.V. announces Conditional stock options granted to Executive Directors of the Company, for the year 2025, based on the general shareholders’ meeting approval from 25 June 20244

- Cha Cha Cha meets crypto: Winz.io partners with European visionary star Käärijä

- Digi Communications N.V. announces the exercise of conditional share options by the executive directors of the Company, for the year 2024, as approved by the Company’s OGSM from 25 June 2024

- “Su Fortuna Se Ha Construido A Base de La Defraudación Fiscal”: Críticas Resurgen Contra Ricardo Salinas en Medio de Nuevas Revelaciones Judiciales y Fiscaleso

- Digi Communications N.V. announces the availability of the instruction regarding the payment of share dividend for the 2024 financial year

- SOILRES project launches to revive Europe’s soils and future-proof farming

- Josh Case, ancien cadre d’ENGIE Amérique du Nord, PDG de Photosol US Renewable Energy et consultant d’EDF Amérique du Nord, engage aujourd’hui toute son énergie dans la lutte contre la dépendance

- Bizzy startet den AI Sales Agent in Deutschland: ein intelligenter Agent zur Automatisierung der Vertriebspipeline

- Bizzy lance son agent commercial en France : un assistant intelligent qui automatise la prospection

- Bizzy lancia l’AI Sales Agent in Italia: un agente intelligente che automatizza la pipeline di vendita

- Bizzy lanceert AI Sales Agent in Nederland: slimme assistent automatiseert de sales pipeline

- Bizzy startet AI Sales Agent in Österreich: ein smarter Agent, der die Sales-Pipeline automatisiert

- Bizzy wprowadza AI Sales Agent w Polsce: inteligentny agent, który automatyzuje budowę lejka sprzedaży

- Bizzy lanza su AI Sales Agent en España: un agente inteligente que automatiza la generación del pipeline de ventas

- Bizzy launches AI Sales Agent in the UK: a smart assistant that automates sales pipeline generation

- As Sober.Buzz Community Explodes Its Growth Globally it is Announcing “Spreading the Good BUZZ” Podcast Hosted by Josh Case Debuting July 7th

- Digi Communications N.V. announces the OGMS resolutions and the availability of the approved 2024 Annual Report

- Escándalo Judicial en Aumento Alarma a la Opinión Pública: Suprema Corte de México Enfrenta Acusaciones de Favoritismo hacia el Aspirante a Magnate Ricardo Salinas Pliego

- Winz.io Named AskGamblers’ Best Casino 2025

- Kissflow Doubles Down on Germany as a Strategic Growth Market with New AI Features and Enterprise Focus

- Digi Communications N.V. announces Share transaction made by a Non-Executive Director of the Company with class B shares

- Salinas Pliego Intenta Frenar Investigaciones Financieras: UIF y Expertos en Corrupción Prenden Alarmas

- Digital integrity at risk: EU Initiative to strengthen the Right to be forgotten gains momentum

- Orden Propuesta De Arresto E Incautación Contra Ricardo Salinas En Corte De EE.UU

- Digi Communications N.V. announced that Serghei Bulgac, CEO and Executive Director, sold 15,000 class B shares of the company’s stock

- PFMcrypto lancia un sistema di ottimizzazione del reddito basato sull’intelligenza artificiale: il mining di Bitcoin non è mai stato così facile

- Azteca Comunicaciones en Quiebra en Colombia: ¿Un Presagio para Banco Azteca?

- OptiSigns anuncia su expansión Europea

- OptiSigns annonce son expansion européenne

- OptiSigns kündigt europäische Expansion an

- OptiSigns Announces European Expansion

- Digi Communications NV announces release of Q1 2025 financial report

- Banco Azteca y Ricardo Salinas Pliego: Nuevas Revelaciones Aumentan la Preocupación por Riesgos Legales y Financieros

- Digi Communications NV announces Investors Call for the presentation of the Q1 2025 Financial Results

- Digi Communications N.V. announces the publication of the 2024 Annual Financial Report and convocation of the Company’s general shareholders meeting for June 18, 2025, for the approval of, among others, the 2024 Annual Financial Report, available on the Company’s website

- La Suprema Corte Sanciona a Ricardo Salinas de Grupo Elektra por Obstrucción Legal

- Digi Communications N.V. announces the conclusion of an Incremental to the Senior Facilities Agreement dated 21 April 2023

- 5P Europe Foundation: New Initiative for African Children

- 28-Mar-2025: Digi Communications N.V. announces the conclusion of Facilities Agreements by companies within Digi Group

- Aeroluxe Expeditions Enters U.S. Market with High-Touch Private Jet Journeys—At a More Accessible Price ↗️

- SABIO GROUP TAKES IT’S ‘DISRUPT’ CX PROGRAMME ACROSS EUROPE

- EU must invest in high-quality journalism and fact-checking tools to stop disinformation

- ¿Está Banco Azteca al borde de la quiebra o de una intervención gubernamental? Preocupaciones crecientes sobre la inestabilidad financiera

- Netmore and Zenze Partner to Deploy LoRaWAN® Networks for Cargo and Asset Monitoring at Ports and Terminals Worldwide

- Rise Point Capital: Co-investing with Independent Sponsors to Unlock International Investment Opportunities

- Netmore Launches Metering-as-a-Service to Accelerate Smart Metering for Water and Gas Utilities

- Digi Communications N.V. announces that a share transaction was made by a Non-Executive Director of the Company with class B shares

- La Ballata del Trasimeno: Il Mediometraggio si Trasforma in Mini Serie

- Digi Communications NV Announces Availability of 2024 Preliminary Financial Report

- Digi Communications N.V. announces the recent evolution and performance of the Company’s subsidiary in Spain

- BevZero Equipment Sales and Distribution Enhances Dealcoholization Capabilities with New ClearAlc 300 l/h Demonstration Unit in Spain Facility

- Digi Communications NV announces Investors Call for the presentation of the 2024 Preliminary Financial Results

- Reuters webinar: Omnibus regulation Reuters post-analysis

- Patients as Partners® Europe Launches the 9th Annual Event with 2025 Keynotes, Featured Speakers and Topics

- eVTOLUTION: Pioneering the Future of Urban Air Mobility

- Reuters webinar: Effective Sustainability Data Governance

- Las acusaciones de fraude contra Ricardo Salinas no son nuevas: una perspectiva histórica sobre los problemas legales del multimillonario

- Digi Communications N.V. Announces the release of the Financial Calendar for 2025

- USA Court Lambasts Ricardo Salinas Pliego For Contempt Of Court Order

- 3D Electronics: A New Frontier of Product Differentiation, Thinks IDTechEx

- Ringier Axel Springer Polska Faces Lawsuit for Over PLN 54 million

- Digi Communications N.V. announces the availability of the report on corporate income tax information for the financial year ending December 31, 2023

- Unlocking the Multi-Million-Dollar Opportunities in Quantum Computing

- Digi Communications N.V. Announces the Conclusion of Facilities Agreements by Companies within Digi Group

- The Hidden Gem of Deep Plane Facelifts

- KAZANU: Redefining Naturist Hospitality in Saint Martin ↗️

- New IDTechEx Report Predicts Regulatory Shifts Will Transform the Electric Light Commercial Vehicle Market

- Almost 1 in 4 Planes Sold in 2045 to be Battery Electric, Finds IDTechEx Sustainable Aviation Market Report

- Digi Communications N.V. announces the release of Q3 2024 financial results

- Digi Communications NV announces Investors Call for the presentation of the Q3 2024 Financial Results

- Pilot and Electriq Global announce collaboration to explore deployment of proprietary hydrogen transport, storage and power generation technology

- Digi Communications N.V. announces the conclusion of a Memorandum of Understanding by its subsidiary in Romania

- Digi Communications N.V. announces that the Company’s Portuguese subsidiary finalised the transaction with LORCA JVCO Limited

- Digi Communications N.V. announces that the Portuguese Competition Authority has granted clearance for the share purchase agreement concluded by the Company’s subsidiary in Portugal

- OMRON Healthcare introduceert nieuwe bloeddrukmeters met AI-aangedreven AFib-detectietechnologie; lancering in Europa september 2024

- OMRON Healthcare dévoile de nouveaux tensiomètres dotés d’une technologie de détection de la fibrillation auriculaire alimentée par l’IA, lancés en Europe en septembre 2024

- OMRON Healthcare presenta i nuovi misuratori della pressione sanguigna con tecnologia di rilevamento della fibrillazione atriale (AFib) basata sull’IA, in arrivo in Europa a settembre 2024

- OMRON Healthcare presenta los nuevos tensiómetros con tecnología de detección de fibrilación auricular (FA) e inteligencia artificial (IA), que se lanzarán en Europa en septiembre de 2024

- Alegerile din Moldova din 2024: O Bătălie pentru Democrație Împotriva Dezinformării

- Northcrest Developments launches design competition to reimagine 2-km former airport Runway into a vibrant pedestrianized corridor, shaping a new era of placemaking on an international scale

- The Road to Sustainable Electric Motors for EVs: IDTechEx Analyzes Key Factors

- Infrared Technology Breakthroughs Paving the Way for a US$500 Million Market, Says IDTechEx Report

- MegaFair Revolutionizes the iGaming Industry with Skill-Based Games

- European Commission Evaluates Poland’s Media Adherence to the Right to be Forgotten

- Global Race for Autonomous Trucks: Europe a Critical Region Transport Transformation

- Digi Communications N.V. confirms the full redemption of €450,000,000 Senior Secured Notes

- AT&T Obtiene Sentencia Contra Grupo Salinas Telecom, Propiedad de Ricardo Salinas, Sus Abogados se Retiran Mientras Él Mueve Activos Fuera de EE.UU. para Evitar Pagar la Sentencia

- Global Outlook for the Challenging Autonomous Bus and Roboshuttle Markets

- Evolving Brain-Computer Interface Market More Than Just Elon Musk’s Neuralink, Reports IDTechEx

- Latin Trails Wraps Up a Successful 3rd Quarter with Prestigious LATA Sustainability Award and Expands Conservation Initiatives ↗️

- Astor Asset Management 3 Ltd leitet Untersuchung für potenzielle Sammelklage gegen Ricardo Benjamín Salinas Pliego von Grupo ELEKTRA wegen Marktmanipulation und Wertpapierbetrug ein

- Digi Communications N.V. announces that the Company’s Romanian subsidiary exercised its right to redeem the Senior Secured Notes due in 2025 in principal amount of €450,000,000

- Astor Asset Management 3 Ltd Inicia Investigación de Demanda Colectiva Contra Ricardo Benjamín Salinas Pliego de Grupo ELEKTRA por Manipulación de Acciones y Fraude en Valores

- Astor Asset Management 3 Ltd Initiating Class Action Lawsuit Inquiry Against Ricardo Benjamín Salinas Pliego of Grupo ELEKTRA for Stock Manipulation & Securities Fraud

- Digi Communications N.V. announced that its Spanish subsidiary, Digi Spain Telecom S.L.U., has completed the first stage of selling a Fibre-to-the-Home (FTTH) network in 12 Spanish provinces

- Natural Cotton Color lancia la collezione "Calunga" a Milano

- Astor Asset Management 3 Ltd: Salinas Pliego Incumple Préstamo de $110 Millones USD y Viola Regulaciones Mexicanas

- Astor Asset Management 3 Ltd: Salinas Pliego Verstößt gegen Darlehensvertrag über 110 Mio. USD und Mexikanische Wertpapiergesetze

- ChargeEuropa zamyka rundę finansowania, której przewodził fundusz Shift4Good tym samym dokonując historycznej francuskiej inwestycji w polski sektor elektromobilności

- Strengthening EU Protections: Robert Szustkowski calls for safeguarding EU citizens’ rights to dignity

- Digi Communications NV announces the release of H1 2024 Financial Results

- Digi Communications N.V. announces that conditional stock options were granted to a director of the Company’s Romanian Subsidiary

- Digi Communications N.V. announces Investors Call for the presentation of the H1 2024 Financial Results

- Digi Communications N.V. announces the conclusion of a share purchase agreement by its subsidiary in Portugal

- Digi Communications N.V. Announces Rating Assigned by Fitch Ratings to Digi Communications N.V.

- Digi Communications N.V. announces significant agreements concluded by the Company’s subsidiaries in Spain

- SGW Global Appoints Telcomdis as the Official European Distributor for Motorola Nursery and Motorola Sound Products

- Digi Communications N.V. announces the availability of the instruction regarding the payment of share dividend for the 2023 financial year

- Digi Communications N.V. announces the exercise of conditional share options by the executive directors of the Company, for the year 2023, as approved by the Company’s Ordinary General Shareholders’ Meetings from 18th May 2021 and 28th December 2022

- Digi Communications N.V. announces the granting of conditional stock options to Executive Directors of the Company based on the general shareholders’ meeting approval from 25 June 2024

- Digi Communications N.V. announces the OGMS resolutions and the availability of the approved 2023 Annual Report

- Czech Composer Tatiana Mikova Presents Her String Quartet ‘In Modo Lidico’ at Carnegie Hall

- SWIFTT: A Copernicus-based forest management tool to map, mitigate, and prevent the main threats to EU forests

- WickedBet Unveils Exciting Euro 2024 Promotion with Boosted Odds

- Museum of Unrest: a new space for activism, art and design

- Digi Communications N.V. announces the conclusion of a Senior Facility Agreement by companies within Digi Group

- Digi Communications N.V. announces the agreements concluded by Digi Romania (formerly named RCS & RDS S.A.), the Romanian subsidiary of the Company

- Green Light for Henri Hotel, Restaurants and Shops in the “Alter Fischereihafen” (Old Fishing Port) in Cuxhaven, opening Summer 2026

- Digi Communications N.V. reports consolidated revenues and other income of EUR 447 million, adjusted EBITDA (excluding IFRS 16) of EUR 140 million for Q1 2024

- Digi Communications announces the conclusion of Facilities Agreements by companies from Digi Group

- Digi Communications N.V. Announces the convocation of the Company’s general shareholders meeting for 25 June 2024 for the approval of, among others, the 2023 Annual Report

- Digi Communications NV announces Investors Call for the presentation of the Q1 2024 Financial Results

- Digi Communications intends to propose to shareholders the distribution of dividends for the fiscal year 2023 at the upcoming General Meeting of Shareholders, which shall take place in June 2024

- Digi Communications N.V. announces the availability of the Romanian version of the 2023 Annual Report

- Digi Communications N.V. announces the availability of the 2023 Annual Report

- International Airlines Group adopts Airline Economics by Skailark ↗️

- BevZero Spain Enhances Sustainability Efforts with Installation of Solar Panels at Production Facility

- Digi Communications N.V. announces share transaction made by an Executive Director of the Company with class B shares

- BevZero South Africa Achieves FSSC 22000 Food Safety Certification

- Digi Communications N.V.: Digi Spain Enters Agreement to Sell FTTH Network to International Investors for Up to EUR 750 Million

- Patients as Partners® Europe Announces the Launch of 8th Annual Meeting with 2024 Keynotes and Topics

- driveMybox continues its international expansion: Hungary as a new strategic location

- Monesave introduces Socialised budgeting: Meet the app quietly revolutionising how users budget

- Digi Communications NV announces the release of the 2023 Preliminary Financial Results

- Digi Communications NV announces Investors Call for the presentation of the 2023 Preliminary Financial Results

- Lensa, един от най-ценените търговци на оптика в Румъния, пристига в България. Първият шоурум е открит в София

- Criando o futuro: desenvolvimento da AENO no mercado de consumo em Portugal

- Digi Communications N.V. Announces the release of the Financial Calendar for 2024

- Customer Data Platform Industry Attracts New Participants: CDP Institute Report

- eCarsTrade annonce Dirk Van Roost au poste de Directeur Administratif et Financier: une décision stratégique pour la croissance à venir

- BevZero Announces Strategic Partnership with TOMSA Desil to Distribute equipment for sustainability in the wine industry, as well as the development of Next-Gen Dealcoholization technology

- Editor's pick archive....